Magento2-教你如何安裝Robots.txt?

Magento2. 三步驟安裝Robots.txt

Robots.txt是一個簡單的txt文件,功能是對搜尋引擎制定搜尋規則,也可以說是搜尋引擎與網站間的協議,告訴搜尋引擎那些網站內容可以被索引,那些是拒絕被索引的。

下面將說明如何在Magento2後台管理Robots.txt:

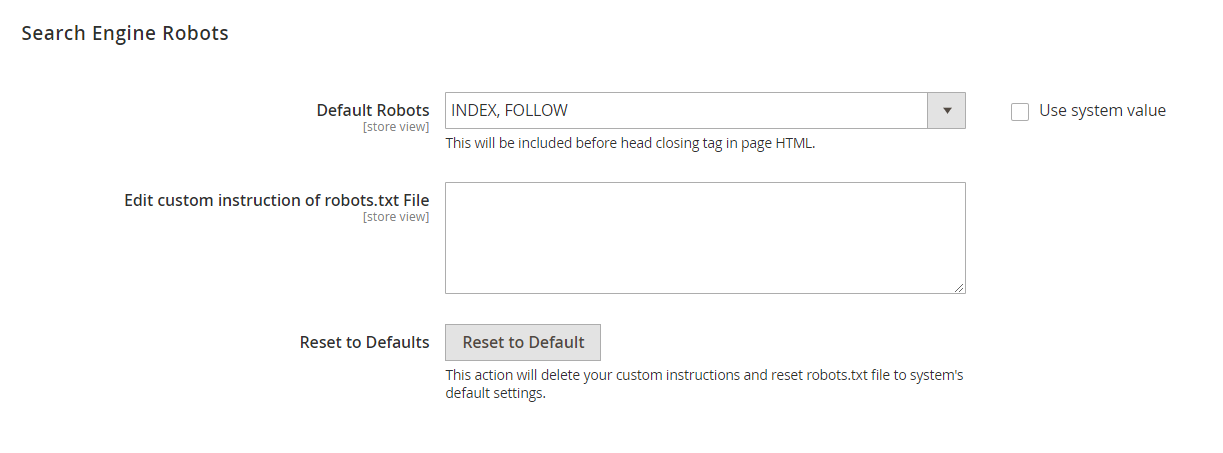

步驟一. 進入Stores> Configuration> General> Design> Search Engine Robots

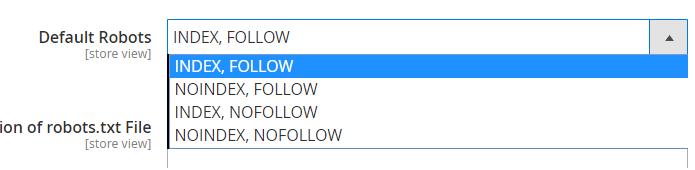

步驟二. 選擇Default Robots

Index為接受網路爬蟲索引到您的網頁,Noindex則為相反,Follow為接受網路爬蟲利用網頁連結索引到其他頁面,Nofollow則為相反。

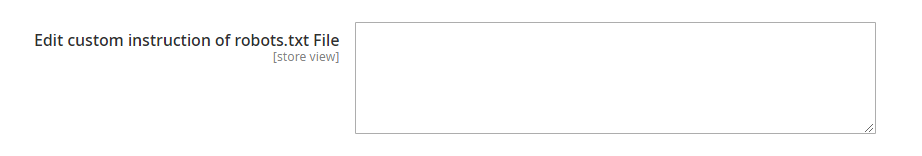

步驟三. 客製化您的Robots.txt

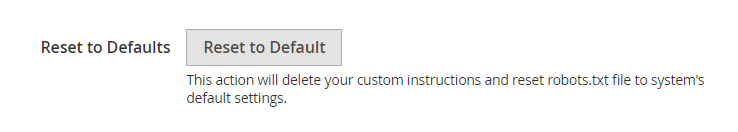

若您需要客製您的Robots.txt,可以在上圖欄位上輸入您的指示,若您需要重置為預設,可以點擊下方按鈕Reset to Default,若您要儲存您所做的所有設定,請按下保存設定Save Config。

指示簡單說明及範例

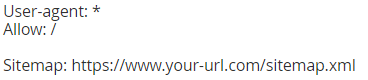

User-agent: 放在robot.txt的第一行,代表遵守下列規則的網路爬蟲,例如: googlebot、 *(所有的網路爬蟲)等。

Allow: 代表允許指示,項目以正斜線 / 作為開頭。

Disallow: 代表不允許指示,項目以正斜線 / 作為開頭,例如: / (封鎖整個網站)、/ 網頁.html (封鎖某個網頁)、/ 目錄 / (封鎖某個目錄)等。

範例一

允許所有爬蟲索引到您的網頁,並參照您的site map。

範例二

拒絕所有爬蟲索引到資料夾1

範例三

拒絕googlebot索引到資料夾1及資料夾2

想要學更多Magento2 後台操作方法嗎? 歡迎參考 Magento教學導覽

我要留言